Google I/O Keynoteまとめ:現実にも検索を。情報を整理する新機能が発表

2019年5月6日(現地時刻)Google I/O 2019のKeynoteからAndroid開発に関係するトピックをお届けします。キーノートの動画も公開されました。デモは理解の手助けになるのでぜひ気になるトピックの部分を見てください。

※現地通信環境が悪くて画像のアップロードは随時実施しています(結構のんびりなのできょう一日ぐらいリロードするかんじでお楽しみください。日本時間5/8 8:00ごろに本記事分の画像追加が終わりました…!)

社会的意義が広がるGoogleの事業

現代ではAndroidをはじめとしたモバイルデバイスはバージョンやOSの差こそあれ、誰もがもっとも長く一緒にいる情報媒体になっています。これまで以上に利用シーンも増え、対象者も広がっています(家族、とくにリテラシーが身につく前の子どもであったり、教育の充実していない発展途上国であったりと様々な人々が対象です)。

自宅や会社、日々の行動などプライバシーを守るための取り組みとその基盤となるセキュリティ強化が強く訴求されたキーノートになりました。技術的な内容はDeveloper Keynoteに譲り、モバイルに関係する内容をいくつか紹介します。

現実世界での検索が強化

サンダー・ピチャイ氏はGoogleのミッションは「世界の情報を集約し、だれもが活用できるようにすることだ」と前置きし、人々を助ける機能として検索機能の強化に触れていました。

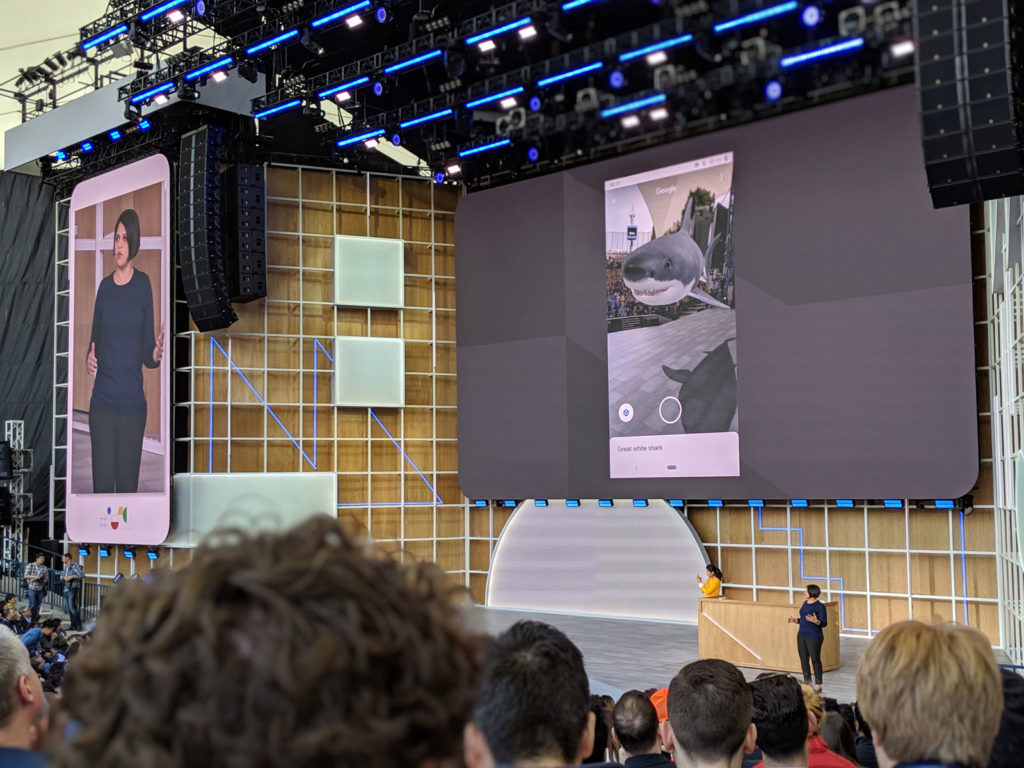

検索はこれまでインデクシングされた内容をランキングし、上から順番に眺めるものでしたが新しい検索では、命名者や最新の情報を時系列に整理したストーリータイムライン、ARによる3D表示などを組み合わせて理解を促進しています。

これらの改善はWebが対象だった検索を現実にも広げ、正しい情報を選ぶコストの低減を訴求するものです。

生活をサポートするGoogle LensとAssistant

Google Lensでは言語翻訳機能のアップデートがありました。撮影した内容を使用者がわかる言語へ変換し、読み上げる事が可能です。これらはインターネットを介さず、ローカル環境で高速に処理できます。

機械学習はGoogle Lensに代表されるアプリケーションで活用されており、Assistantやアプリケーションでも情報を分かる形で整理しています。生活を便利にする形のひとつといえるでしょう。

電話から飛び出たDuplex on the Web

前回のGoogle I/Oで発表された電話の自動応答サービスDuplexはWebサイトにも対応しました。 音声で予約を頼むとGmailなどの注文履歴をみて、Webでのフォームを自動で埋めてくれます。

検索がユーサー環境へ拡大

これらの現実空間との融合を実現するためには、機械学習のモデルをローカル実行する技術的なジャンプを行っています。さきほどの言語翻訳はたった数百キロバイトで実現しており、Google Assistantは0.5GBのローカル実行環境を用意して10Xの高速化を実現しています。

いままではWebが検索対象はWebが支配的でしたが現実という大きな情報空間を対象に変化しつつあります。生活の隅々に検索を浸透し、人々の生活を向上させることを印象づけたキーノートでした。

リアルタイムの情報提供と個人学習の最適化

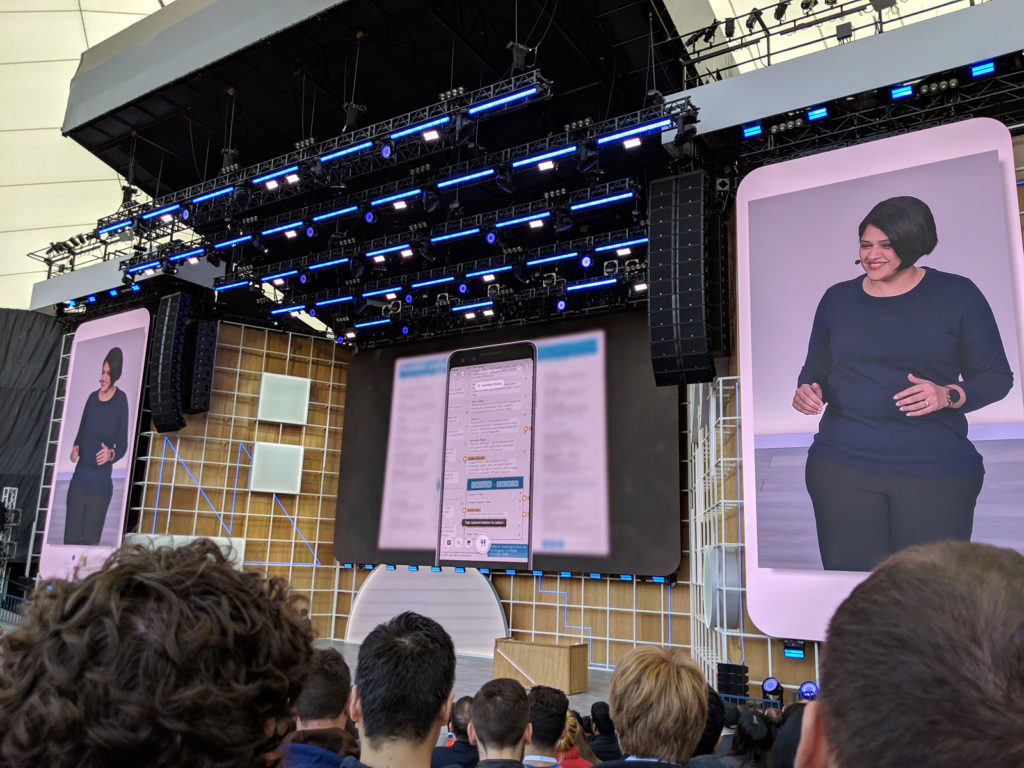

現実での情報提供をスムーズにする機能が4つあり、ライブでの翻訳を提供するLive Transcribe、文字起こしを行うLive Caption、 テキストと音声を変換するLive Relay、個人の癖を掴み音声入力の精度をあげるProject Euphoniaです。

4つの取り組みは現実へ進出する足がかりとして順次提供見込みです。Android QでもLive Captionのデモがあり、スムーズに動作していました。

特にLive Captionのような文字起こし機能は、モバイル環境でのビデオ再生時は音声がオフなのが80%超えるとの調査もあるぐらい、音声と映像が分離する現状において、音声を文字情報に変換することでコンテキストが明らかになります。誰にとっても便利で有用な機能といえるでしょう(たとえば動画広告などでも喜ばれるとおもいますが、映画やドラマなど音声を前提とした媒体に特に有効です)。

検索におけるプライバシーも配慮

- 検索情報がどの程度残すのか、ユーザーが選択可能になる

- Android Qでもプライバシーが強化されている。

これらプライバシーとセキュリティの強化も社会的責任を果たす一貫と捉えることができます。Android Qのプライバシー機能追加(とそのためのセキュリティ強化)はこのような背景のもと行われています。

家庭に浸透するGoogleテクノロジー

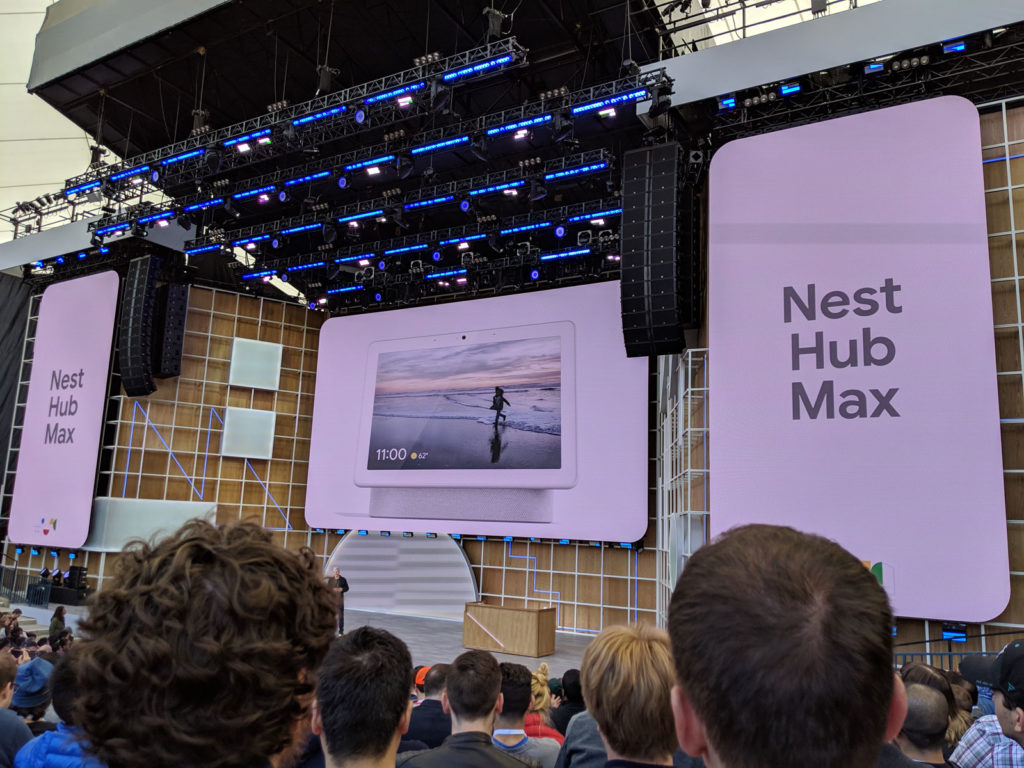

AIの利用シーン拡大に合わせてGoogle Home HubをNest Hubとリネームしたことが発表されました。あわせてNest Hub Maxを発表しています。

Nest Hubは名前からわかるとおり家庭用デバイスNestと連携を前提としており、玄関のカメラ、エアコン調整などが可能でビデオ通話のGoogle DuoやGoogle アシスタントなどと連携できるスマートホームのためのデバイスです。

What’s Next?

Android関係は量が増えてきたので記事をわけてこちらで更新中です!引き続きお楽しみください。

会場は超満員でした。引き続き会場から情報をお伝えしてきます!